אופטימיזציה של Robots.txt עבור SEO

על ידי rina_designer | ינו 4, 2022 | seo, גוגל

https://www.wpbeginner.com/wp-tutorials/how-to-optimize-your-wordpress-robots-txt-for-seo/

רובוט טקסט (Robots.txt) זהו קובץ שאומר למנועי החיפוש כיצד לסרוק את האתר שלכם.

במאמר זה אראה לכם כיצד ליצור קובץ Robots.txt מושלם לקידום אתרים.

מהו קובץ רובוט טקסט (robots.txt)?

Robots.txt הוא קובץ טקסט שבעלי אתרים יכולים ליצור כדי לומר לבוטים של מנועי חיפוש כיצד והאם לסרוק דפים באתר שלכם.

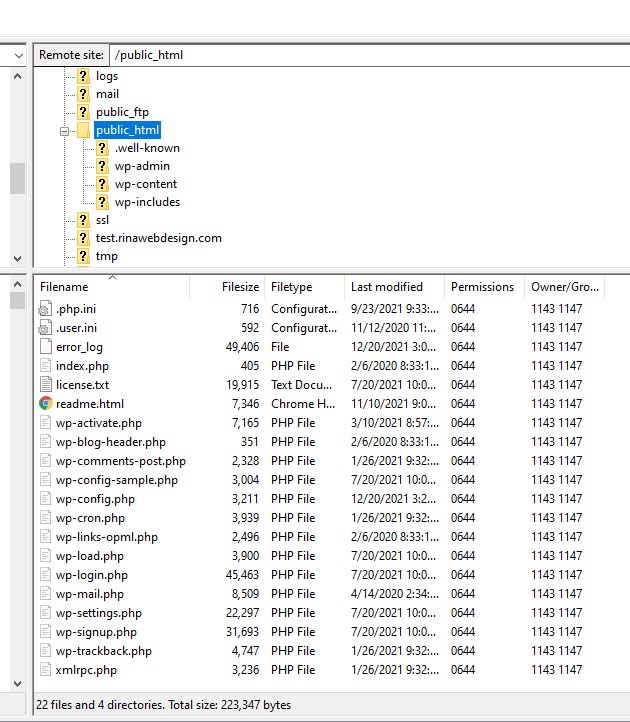

הקובץ מאוחסן בדרך כלל בספריית השורש, הידועה גם בתור התיקיה הראשית, של האתר שלכם.

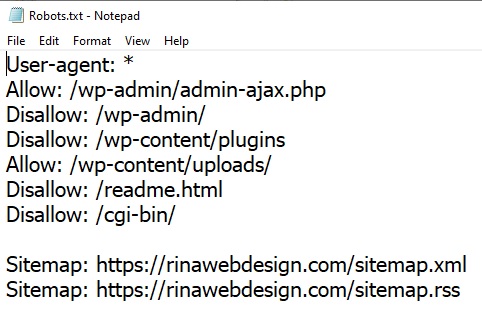

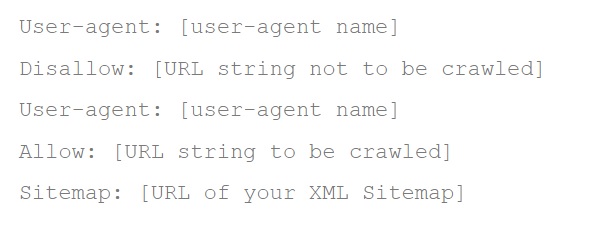

הפורמט הבסיסי של קובץ robots.txt נראה כך:

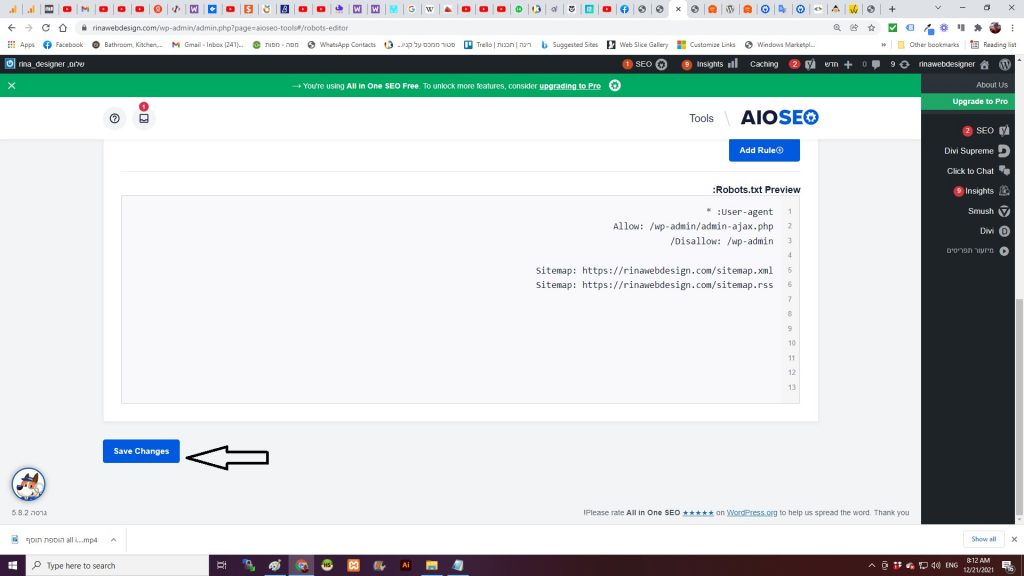

User-agent: [user-agent name]Disallow: [URL string not to be crawled] User-agent: [user-agent name]Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap]כך יכול להיראות קובץ robots.txt לדוגמה:

User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/Sitemap: https://example.com/sitemap_index.xmlבדוגמה של רובוט טקסט לעיל,

בשורה ראשונה – אפשרנו למנועי חיפוש לסרוק קבצים באינדקס בתיקיית uploads של וורדפרס שלנו.

בשורות שניה ושלישית – הודענו לבוטים לחיפוש לא לסרוק ולא להוסיף לאינדקס תוספים ותיקיות ניהול וורדפרס.

לבסוף – סיפקנו את כתובת האתר של מפת ה-XML שלנו.

האם כולם צריכים קובץ רובוט טקסט ( Robots.txt ) לאתר וורדפרס?

גם אם אין לכם קובץ רובוט טקסט, מנועי החיפוש יסרקו ויוסיפו לאינדקס את האתר שלכם. עם זאת, לא תוכלו לומר למנועי החיפוש אילו דפים או תיקיות הם לא צריכים לסרוק.

עם זאת, ככל שהאתר שלכם גדל ויש לכם תוכן רב, סביר להניח שתרצו לקבל שליטה טובה יותר על אופן הסריקה והאינדקס של האתר.

הנה הסיבה.

לבוטים לחיפוש יש מכסת סריקה לכל אתר.

המשמעות היא שהם סורקים מספר מסוים של דפים במהלך סשן סריקה. אם הם לא יסיימו לסרוק את כל הדפים באתר שלכם, הם יחזרו ויחדשו את הסריקה בהפעלה הבאה.

זה יכול להאט את קצב ההוספה לאינדקס של האתר שלכם.

אתם יכולים לתקן זאת על ידי מניעת ניסיון לבוטים של חיפוש לסרוק דפים מיותרים כמו דפי הניהול שלכם ב-WordPress, קבצי פלאגין ותיקיית ערכות נושא.

על ידי אי אישור של דפים מיותרים, אתם חוסכים את מכסת הסריקה שלכם.

זה עוזר למנועי החיפוש לסרוק עוד יותר דפים באתר שלכם ולהוסיף אותם לאינדקס במהירות האפשרית.

סיבה טובה נוספת להשתמש בקובץ רובוט טקסט היא שכאשר אתם רוצים למנוע ממנועי חיפוש להוסיף לאינדקס פוסט או דף באתר שלכם – תגדירו אותם כדפים לא לסריקה.

זו לא הדרך הבטוחה להסתיר תכנים מהציבור הרחב, אבל היא תעזור לכם למנוע את הופעתם בתוצאות החיפוש.

איך נראה קובץ Robots.txt אידאלי?

בלוגים פופולריים רבים משתמשים בקובץ robots.txt פשוט מאוד. התוכן שלהם עשוי להשתנות, בהתאם לצרכים של האתר הספציפי:

User-agent: *Disallow:Sitemap: http://www.example.com/post-sitemap.xmlSitemap: http://www.example.com/page-sitemap.xmlקובץ robots.txt זה מאפשר לכל הבוטים להוסיף לאינדקס את כל התוכן ומספק להם קישור למפות ה-XML של האתר.

עבור אתרי וורדפרס, מומלץ על הכללים הבאים בקובץ robots.txt:

User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-admin/Disallow: /readme.htmlDisallow: /refer/Sitemap: http://www.example.com/post-sitemap.xmlSitemap: http://www.example.com/page-sitemap.xmlזה אומר לבוטים להוסיף לאינדקס את כל התמונות והקבצים של וורדפרס. ולא מאפשר לבוטים להוסיף לאינדקס את אזור הניהול של וורדפרס, קובץ ה-readme.

על ידי הוספת מפות אתר לקובץ robots.txt, אתם נותנים הוראה לבוטים של גוגל למצוא את כל הדפים באתר שלכם.

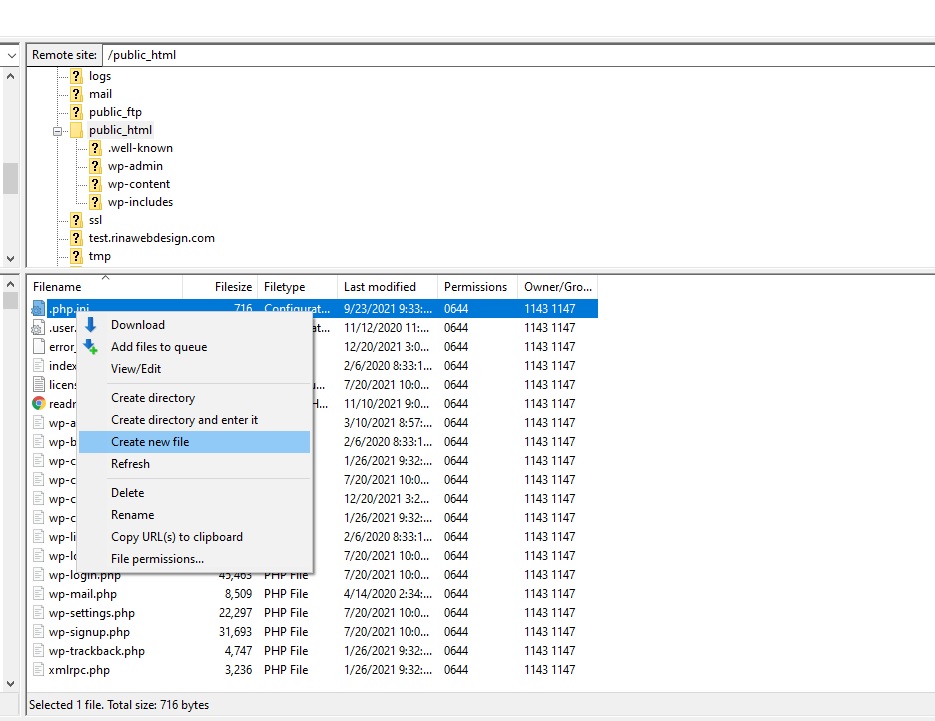

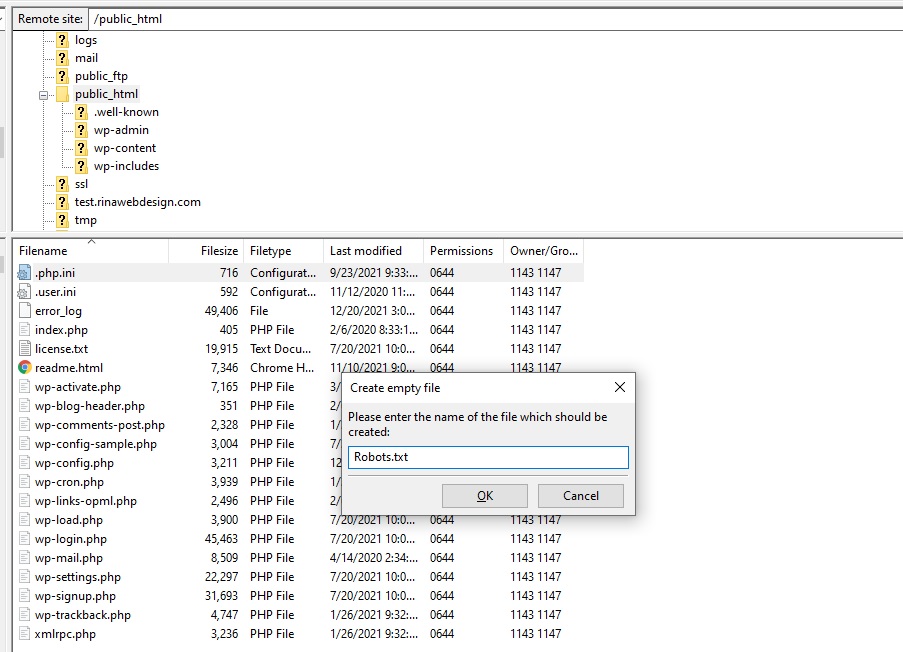

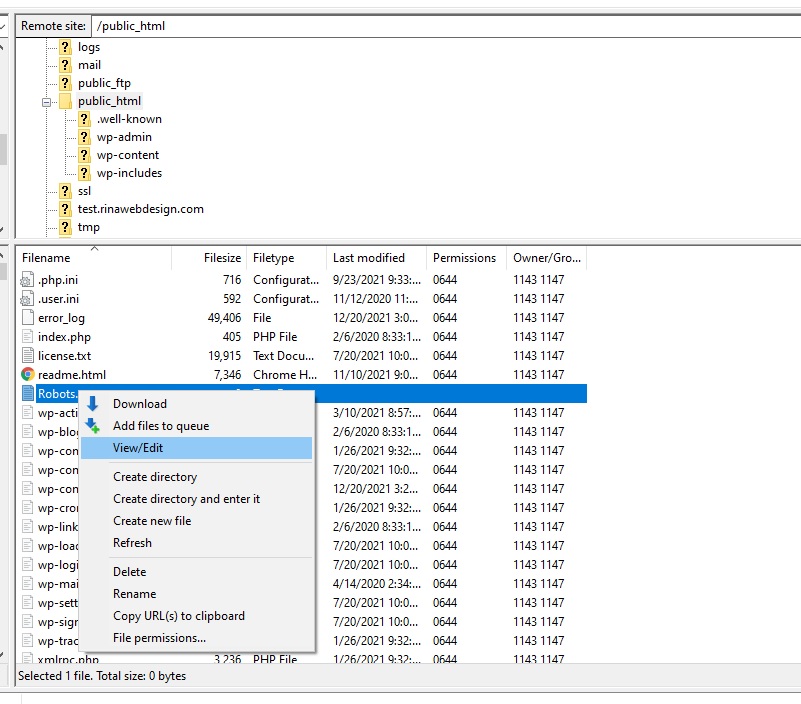

עכשיו כשאתם יודעים איך נראה קובץ robots.txt אידיאלי, בואו נסתכל על איך אתם יכולים ליצור קובץ robots.txt בוורדפרס.